Temas de tesis

Reconstrucción de interiores

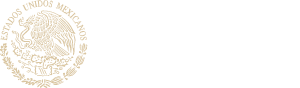

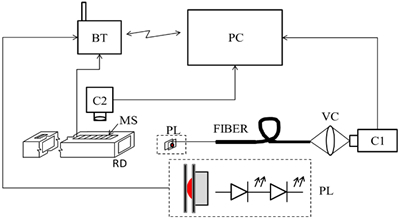

El objetivo de este proyecto es presentar un fibroscopio modificado para el escaneo en 3D del interior de partes con difícil acceso. La modificación consiste principalmente en la sustitución del sistema de iluminación original del fibroscopio por un sistema que proyecta una línea de luz que revela el perfil interior del objeto bajo estudio. La línea de luz se obtiene mediante un LED de potencia (PL) encerrado entre 2 capas y unido mediante una extensión a la punta del fibroscopio. La intensidad del PL es controlada de manera inalámbrica a través de un módulo con interfaz BlueTooth (BT) que se conecta a la computadora (PC). Imágenes del perfil interior del objeto son capturadas por una cámara (C1) conectada al ocular del fibroscopio mediante un video-acoplador (VC). Utilizando una serie de esas imágenes en diferentes secciones transversales, el sistema es capaz de capturar una nube de puntos que servirán más tarde para generar un escaneo 3D del objeto con exactitud sub-milimétrica.

Este trabajo también propone el uso de una combinación de filtros conocidos para eliminar las estructuras de panal de abeja producidas por el fibroscopio y el uso de anillos patrón para corregir los parámetros intrínsecos de la cámara conectada al fibroscopio y la trazabilidad metrológica del sistema. Varias mediciones del diámetro de anillos fueron comparadas contra su valor certificado para mejorar la exactitud del sistema. Como ejemplo de aplicación del sistema propuesto, se llevó a cabo un escaneo 3D del interior del conducto de un refrigerador (RD). Este escaneo incluye la evaluación de la exactitud mediante la comparación de las mediciones del sistema contra una máquina de medición por coordenadas (CMM).

El sistema descrito es capaz de escanear en 3D el interior de los objetos con perfiles uniformes y no uniformes de 20 a 60 mm en dimensiones transversales. La profundidad alcanzada es de 1000 mm si el material de las paredes del objeto es translúcido y permite la detección de la potencia de luz LED desde el exterior a través de la pared mediante una cámara (C2). La profundidad se mantiene si se utiliza la escala de una CMM u otro sistema de traslación con tal alcance; si esto no es posible, se propone el uso de una escala magnética (MS) que reduce la profundidad de trabajo a 170 mm.

El error de medición del sistema es de alrededor de ± 0.15 mm en el escaneo 3D de las secciones transversales 2D y ± 1.3 mm en posición utilizando una escala magnética, ± 0.5 mm usando una cámara CCD (C2) y un valor dependiente de la exactitud de posicionamiento de la escala del sistema de traslación o CMM utilizados.

Finalmente este trabajo realiza una caracterización del sistema propuesto mediante un análisis de los factores que afectan la incertidumbre de medición.

Figura 1. Diagrama del arreglo experimental (Icasio, 2014)

Fig. 2: Sistema de visión activa para el dimensionamiento del interior de objetos. a) y b) Generación de la línea de luz, c) Cámara conectada al ocular del fibroscopio por medio de un video acoplador.

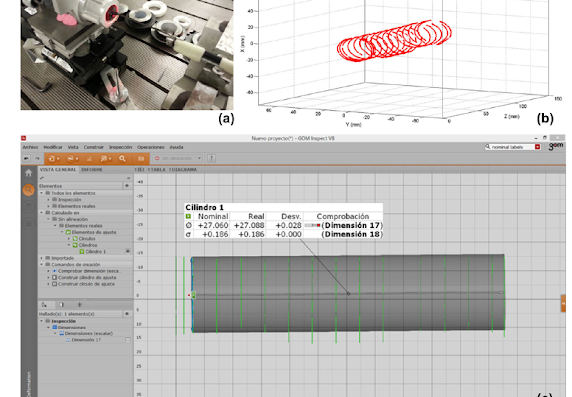

Para probar el método de calibración y su error de medición, se midió el interior de un cilindro maestro de acuerdo con la Fig. 3a. Un cilindro maestro es una parte importante del sistema de frenos de un automóvil y sus tolerancias son estrechas. Los datos de entrada consistieron en una secuencia de 16 imágenes, cada una de las cuales produjo puntos 3D con forma de elipse. Entre imágenes sucesivas, el sensor se movió en pasos de 15 mm a lo largo la dirección z del sistema de coordenadas del sensor, que cubre la mayor parte del interior del cilindro maestro. De acuerdo con el dibujo técnico, el diámetro del cilindro que se puede ajustar internamente debe ser de 27.06 mm (valor nominal) con una tolerancia de ± 0.025 mm. La figura 3c muestra cómo ajustando algunos de los puntos 3D escaneados de la figura 3b en un cilindro obtuvimos un diámetro de 27.088 mm, lo que significa un error de 0.028 mm contra el valor nominal y 0.003 mm fuera de tolerancia. El cilindro también se midió con un CMM, y el valor informado por el CMM fue de 27.075 mm, por lo que el error contra el valor de CMM es de solo 0.013 mm, lo que garantiza la confianza del método propuesto. Los puntos 3D instalados en un cilindro se realizaron con el software de certificado GOM Inspect V8. (Icasio, 2019)

Fig. 3 a) Configuración para el escaneo 3D del cilindro maestro, b) Escaneo 3D del cilindro maestro y c) cilindro equipado con algunos de los puntos 3D de la Fig. 2b (Icasio, 2019)

Proyectos propuestos

Escaneo tridimensional usando un videoscopio (Tema de tesis de maestría). El fibroscopio presente características muy particulares en la imagen. En este proyecto el estudiante usará un videoscopio para la adquisición de imágenes y utilizará un láser para generar la franja de luz usada para el escaneo. Se integrará un sistema de posicionamiento que permita determinar la posición del sistema de visión activo dentro del interior del objeto a escanear, con el objetivo de conocer la tercera coordenada.

Influencia de factores que afectan la calibración (Tema de tesis de doctorado). En este tema de tesis se analizará el sistema de escaneo utilizando el fibroscopio y el videoscopio. El objetivo es encontrar las etapas y parámetros más sensibles en la calibración y escaneo, con el objetivo de proponer un procedimiento de calibración y escaneo adaptado al sistema propuesto.

Medición de roll, yaw y pitch de la punta de un boroscopio y posicionamiento (Tema de tesis de doctorado). Hasta ahora los esfuerzos están orientados a dimensionar el ducto a diferentes profundidades. En este proyecto se propone dimensionar el ducto a diferentes profundidades y calcular la profundidad con el propósito de recuperar la coordenada en “Z”. Por otro lado, se ha considerado que el sistema de escaneo y el ducto están perfectamente alineados, calcular el roll, yaw y pitch nos permitirán corregir los problemas de la no alineación.

Colaboradores:

Dr. José-Joel González-Barbosa

Dr. Juan Bautista Hurtado-Ramos

Dr. Francisco Javier Ornelas-Rodríguez

Dr. Octavio Icasio-Hernández

Dra. Silvia. Cano-Rodríguez

Bibliografía

(Icasio, 2014) Octavio Icasio-Hernández and José-Joel Gonzalez-Barbosa and Juan B Hurtado-Ramos and Miguel Viliesid-Alonso. 3D reconstruction of hollow parts analyzing images acquired by a fiberscope. Measurement Science and Technology. 25 (7). 2014.6841843. https://iopscience.iop.org/article/10.1088/0957-0233/25/7/075402/meta

(Icasio, 2019) Icasio-Hernández, O., Hurtado-Ramos, J.B. & Gonzalez-Barbosa, JJ. Calibration of Endoscopic Systems Coupled to a Camera and a Structured Light Source. MAPAN (2019) 34: 143. https://doi.org/10.1007/s12647-018-0288-y

(Cano 2019) S. Cano-Rodríguez, J. Gonzalez-Barbosa, F. Ornelas-Rodríguez, J. Hurtado-Ramos and O. Icasio-Hernández, Positioning system for 3D scans inside objects, Rev. int. métodos numér. cálc. diseño ing. (2019). Vol. 35, (1), 17. https://www.scipedia.com/public/Cano-Rodriguez_et_al_2018a

Reconstrucción 3D panorámica

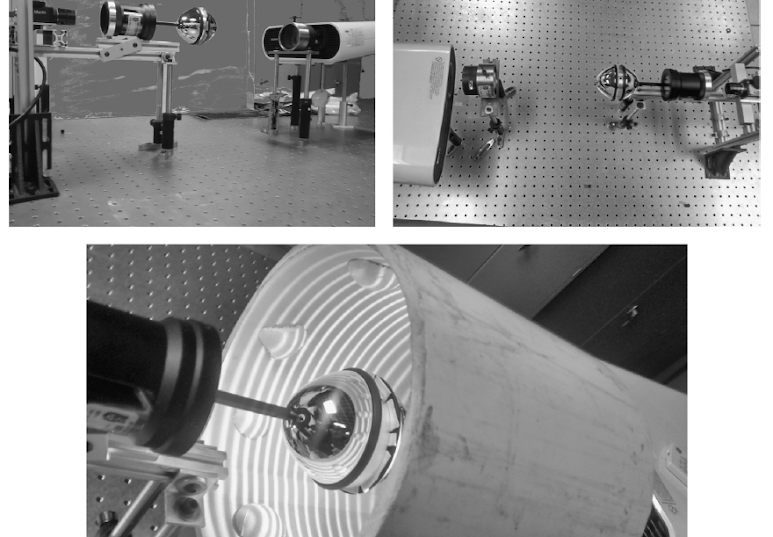

Una cámara catadióptrico consiste de espejos que tienen la forma de una superficie cónica de revolución, es decir, paraboloides (figura 1), elipsoides, hiperboloides o esferas; y una cámara digital es utilizada para adquirir la imagen reflejada por estos (figura 1). Una ventaja de los sistemas catadióptricos es la posibilidad de tener un campo de visión panorámico de 360o en una sola imagen. Mediante la calibración podemos obtener las dimensiones de todo un ambiente o de objetos presentes en la imagen.

Figura 1. Cámara catadióptrica y proyector catadióptrico

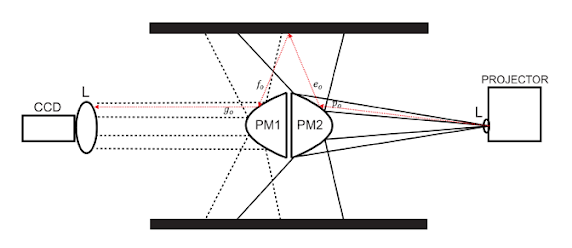

La figura 2, muestra el diagrama experimental cámara-proyector catadióptrico. El sistema está formado por dos módulos. El primer módulo consiste en una cámara catadióptrica compuesta por una cámara CCD y un espejo parabólico, este módulo permite adquirir imágenes panorámicas, el segundo módulo consta de un proyector de luz y un espejo parabólico que se utiliza para generar la proyección de patrones sobre el objeto que se desea escanear. El campo de visión del sistema de proyección es de 360 grados.

Figura 2. Diagrama del arreglo experimental.

El escaneo panorámico tridimensional lo hemos abordado de dos perspectivas: Geométrica (Córdoba, 2014), y por perfilometría (Almaraz, 2016).

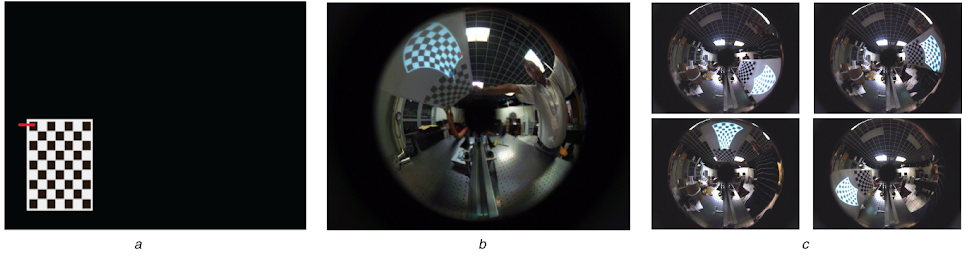

La mayoría de las técnicas estudiadas utilizan un enfoque geométrico, sin embargo el escaneo denso es muy tardado ya que requiere de muchos puntos (pixeles) o imágenes tanto para la calibración como para el escaneo. El trabajo presentado en (Córdoba, 2014) tiene dos aportaciones: calibración y escaneo 3D. Durante la calibración se utilizó un plano que contenía un patrón de calibración impreso y un patrón de calibración proyectado por el sistema PM2-proyector (ver Figura 3). El patrón impreso se usó para calibrar el sistema cámara-PM1, mientras que el patrón proyectado se utilizó para calibrar PM2-proyector y para calcular la matriz de rotación y traslación entre los espejos PM1 y PM2. Durante el escaneo 3D se proyectaron patrones con puntos de colores aleatorios para encontrar correspondencias entre la imagen proyectada y la imagen adquirida mediante las restricciones de cónicas epipolares.

Figura 3. Imagen del plano de calibración que contiene dos patrones tipo tablero de ajedrez, el patrón impreso se utiliza para calibrar la cámara panorámica y el patrón proyectado para calibrar el sistema de proyección catadióptrico.

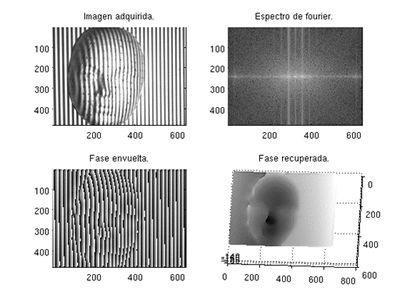

Los sistemas perfilométricos que utilizan la proyección de franjas, son relativamente antiguos y han sido muy estudiados, existen numerosas técnicas para el procesamiento de las imágenes, desde Takeda (Takeda, 1982) que utiliza transformada de Fourier y adquiere sólo una imagen, pasando por algoritmos que procesan varias imágenes que utilizan franjas con cierto desfase siendo estos un poco más precisos aunque su procesamiento necesita más tiempo (Gorthi, 2010). La ventaja es que no necesitamos una superficie de referencia al momento de reconstruir.

Figura 4. Imagen ilustrativa del método de Fourier que muestra la imagen de franjas proyectadas, el espectro de Fourier, la fase envuelta y la fase desenvuelta obtenida finalmente.

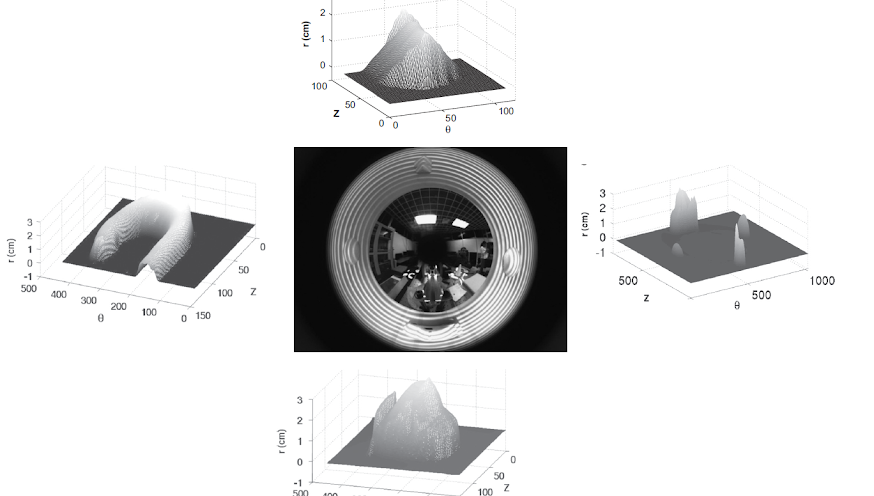

En la figura 5 podemos observar la proyección de franjas sobre la superficie cilíndrica que contiene objetos adheridos a la superficie. A la derecha de la figura observamos los objetos escaneados tridimensionalmente de la proyección de franjas que se observa en el centro de la figura. En la imagen de la izquierda, arriba y abajo de la figura 5 observamos los objetos escaneados tridimensionalmente por el método propuesto.

Figura 5. En el centro se observa una proyección típica de franjas en una superficie cilíndrica que contiene objetos adheridos en su interior. A la derecha observamos es escaneo 3D de los objetos que se encuentran sobre la superficie. Arriba, abajo e izquierda observamos de manera individual los objetos 3D escaneados.

Actualmente estamos desarrollando técnicas de perfilometría por proyección de franjas a un sistema de visión panorámico del tipo catadióptrico. Este consiste en un par de espejos parabólicos colocados a espaldas uno del otro, un proyector y una cámara digital, alrededor de estos se coloca un cilindro de dimensión conocida (ver figura 1 y 2). Aprovechando la simetría del sistema, es posible escanear el interior del cilindro y obtener la forma de los objetos que se encuentren sobre su superficie. Actualmente estudiamos la estructura de franjas más adecuada para lograr un escaneo 3D denso del ambiente, conocer los parámetros del sistema, también observar si todos los algoritmos existentes de perfilometría son aplicables en el arreglo experimental.

Proyectos propuestos.

En este proyecto se han presentado avances significativos. Sin embargo existen áreas de oportunidad que hemos identificado. Los temas que se pueden desarrollar dentro de este proyecto son:

Técnicas de perfilometría panorámica (Tema de tesis de maestría). Se han revisado las técnicas de Fourier (Takeda, 1982), desplazamiento de fases (Creath, 1988 ), y de desenvolvimiento temporal ( Saldner, 1997). En este trabajo, el estudiante deberá implementar otras técnicas, como transformada wavelet, transformada de Fourier ventaneada, etc. y estudiar cuál de ellas da mejores resultados. Igualmente deberá determinar las características estáticas del sistema tales como exactitud, fidelidad, sensibilidad, linealidad, resolución.

Calibración de cámaras catadióptricas (Tema de tesis de doctorado). Actualmente, las cámaras catadióptricas son calibradas utilizando patrones de calibración diseñados para cámaras convencionales, igualmente la metodología es muy parecida a la utilizada en las cámaras convencionales, el modelo de formación de la imagen es la parte que ha sido adaptado. Sin embargo, debido a la forma particular en que la imagen es capturada se deben desarrollar tanto patrones como metodologías de calibración propias para este tipo de cámaras.

Miniaturizar el sistema (Tema de tesis de maestría). En este trabajo se propone al estudiante disminuir a un 10% las dimensiones del sistema experimental actual. Para lograrlo, el estudiante deberá trabajar en el proceso de generación de franjas y el procesamiento de las imágenes deberá hacerse en un sistema embebido.

Proyectar sobre otras superficies no sólo cilindros (Tema de tesis de doctorado). Actualmente el sistema está adaptado para escaneo 3D sobre superficies cilíndricas. En esta propuesta, el estudiante deberá desarrollar el modelo matemático para poder escanear sobre cualquier superficie e implementarlo.

Girar espejos planos para simular un espejo cónico (Tema de tesis de maestría). Actualmente el sistema experimental usa espejos de revolución. Sin embargo es compleja la adquisición de espejos de revolución con las características geométricas adecuadas. Por otro lado el mismo efecto geométrico puede generarse con espejos más fáciles adquisición. El trabajo estará orientado en la geometría cónica de espejos a partir de la rotación de espejos planos.

Colaboradores:

Dr. José-Joel González-Barbosa

Dr. Juan Bautista Hurtado-Ramos

Dr. Francisco Javier Ornelas-Rodríguez

Dra. Diana Margarita Córdova-Esparza

Dr. Cesar Almaraz-Cabral

Bibliografía

(Córdoba, 2014) Córdova-Esparza, D.-M., Gonzalez-Barbosa, J.-J., Hurtado-Ramos, J.-B., Ornelas-Rodriguez, F.-J. A panoramic 3D reconstruction system based on the projection of based on the projection of patterns. International Journal of Advanced Robotic Systems, 11 (1), art. no. 55. 2014. https://doi.org/10.5772/58227

(Almaraz, 2016) Almaraz-Cabral, C.-C., Gonzalez-Barbosa, J.-J., Villa, J., Hurtado-Ramos, J.-B., Ornelas-Rodriguez, F.-J., Córdova-Esparza, D.-M. Fringe projection profilometry for panoramic 3D reconstruction. Optics and Lasers in Engineering, 78, pp. 106-112. 2016. https://doi.org/10.1016/j.optlaseng.2015.10.004

(Córdoba, 2019) Córdova-Esparza, Diana Margarita; González-Barbosa, José-Joel; Terven, Juan R.; Hurtado-Ramos, Juan B.; Almaraz-Cabral, César-Cruz: 'Calibration of a panoramic 3D reconstruction system', IET Image Processing, 2019, 13, (6), p. 1006-1015, DOI: 10.1049/iet-ipr.2018.5365

Patente MX/a/2011/013957. Interferómetro panorámico de patrones de moteado láser con espejo convexo único. 5 de Agosto del 2013.

(Takeda, 1982) Takeda, Mitsuo, Ina, Hideki, Kobayashi, Seiji. Fourier-Transform Method Of Fringe-Pattern Analysis For Computer-Based Topography And Inteferometry. Journal of the Optical Society of America, 72 (1), pp. 156-160. 1982

(Gorthi, 2010) S.S.Gorthi and P.Rastogi. Fringe projection techniques : Whither we are?. Opt.LasersEng.,48(2):133–140. 2010.

(Creath,1998) Creath, K. Phase-measurement interferometry techniques. Progress in optics, 26(26), 349-393, 1998.

(Saldner,1997) Saldner, H. O., & Huntley, J. M. Temporal phase unwrapping: application to surface profiling of discontinuous objects. Applied optics, 36(13), 2770-2775, 1997.

Realidad virtual

La Realidad Virtual se refiere a la tecnología que es capaz de trasladar a una persona a un ambiente diferente sin moverlo físicamente. Para hacerlo, las entradas sensoriales de la persona son manipuladas de tal manera que el ambiente percibido se asocia con un Ambiente Virtual deseado y no con el ambiente físico real. El proceso de manipulación está controlado por un modelo de computadora que se basa en la descripción física del Ambiente Virtual. En consecuencia, la tecnología puede crear ambiente percibidos casi arbitrariamente.

PROYECTO 1:

CONSTRUCCIÓN DE MAPAS URBANOS MÓVILES MEDIANTE REALIDAD AUMENTADA PARA APLICACIONES EN ADMINISTRACIÓN URBANA.

Objetivo:

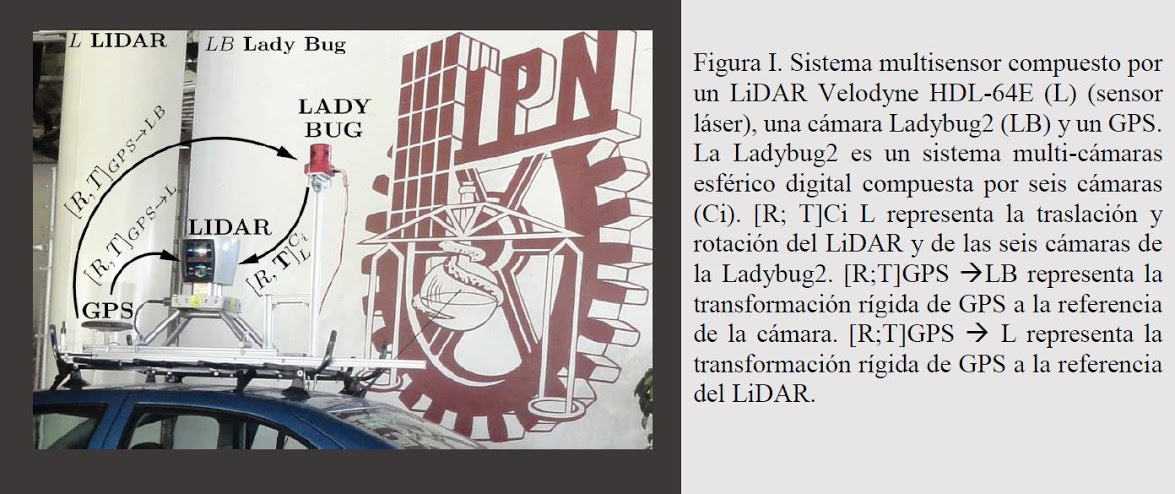

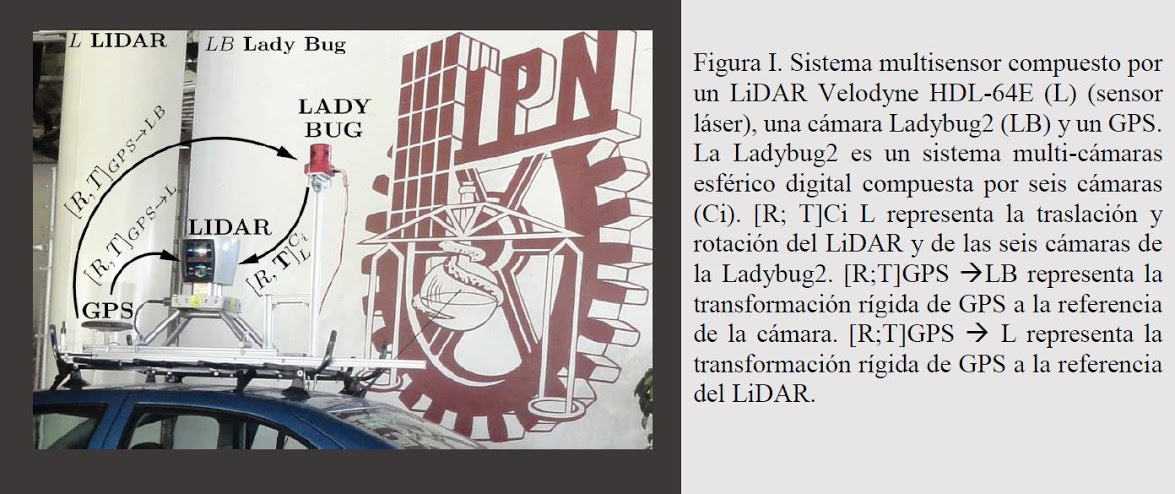

Inspirado en los videojuegos para móviles de realidad aumentada basados en localización del mundo real que implican desplazarse físicamente por las calles de la ciudad para progresar, se propone el desarrollo de un módulo de visualización de elementos viales del entorno (señales viales, semáforos, postes de luz, lámparas) que muestre características cuantitativas (posición satelital, tamaño, conteos, existencia, etc.) y cualitativas (deterioro, grafiti, daño, etc.) previamente adquiridas haciendo uso de información visual por cámaras panorámicas (LadyBug), información espacial por sensores láser (LiDAR) y GPS, con el fin de aplicar la información, en línea o fuera de línea, en administración urbana como en tareas realizadas por la Secretaría de Comunicaciones y Transporte (inventariado, mantenimiento, preservación, etc.).

Recursos disponibles:

Ejemplo de la representación visual:

Figura II. El videojuego para móviles Pokemon Go. Izquiedo captura del entorno basado en localización del mundo real. Derecho: se espera ubicar las señales viales adquiridas previamente en su localización real.

Las señales deberán mostrar su descripción. Ejemplo: Señal 1 (señal de cruce peatonal, se espera cruce de cebra), Señal 2 (señal de prohibido estacionarse, se espera banqueta amarilla). [Imagen google]

Figura III. El videojuego para móviles Wizard Unite. Izquierdo: captura del entorno basado en localización del mundo real. Derecho: se espera ubicar semáforos y postes de luz adquiridas previamente en su localización real. Estos objetos, se describen. Ejemplo: Semáforo: (dimensiones espaciales: altura, color), Poste de Luz (dimensiones espaciales: altura, color). [Imagen: google maps]

Colaboradores:

Dr. José-Joel González-Barbosa

Dr. Juan Bautista Hurtado-Ramos

Dr. Francisco Javier Ornelas-Rodríguez

Dr. Erick-Alejandro González-Barbosa (ITESI-Irapuato)

M. Karen Lizbeth Flores-Rodriguez

Dr. Alfonso Ramírez Pedraza ( Centro de Investigaciones en Óptica A. C. )

Dr. Angel Ivan García Moreno (CIDESI)

Realidad aumentada

La Realidad Aumentada consiste en ofrecer información digital superpuesta a la visión real. El gran auge de los dispositivos móviles ha hecho posible que este tipo de tecnología esté disponible en cualquier momento y lugar, gracias a la inclusión de las cámaras digitales y del aumento de la capacidad de procesamiento de los mismos.

La realidad aumentada espacial (SAR, por sus siglas en inglés), también conocida como mapeo de proyección, hace posible aumentar el mundo real con información virtual por medio de un emisor de luz como un proyector de vídeo. La realidad aumentada espacial empleada en conjunto con un monitor de alta resolución una combinación elegante de razonamiento espacial, interacción tangible y visualización detallada de información.

Las Interfaces de Usuarios de la Realidad Aumentada como la Realidad Virtual han sido utilizado hasta ahora para una gran cantidad de tareas, donde a veces han demostrado ser muy prometedoras para aumentar el rendimiento de un usuario en comparación con las interfaces de usuario tradicionales de ratón y monitor [Krichenbauer et al. [2018]. En [Milgram and Kishino [1994] definen la RA como un camino para "aumentar" el mundo real con objetos virtuales. Más en [Azuma et al. [2001] propone que los sistemas de RA deben tener las siguientes propiedades: es la combinación de objetos reales y virtuales en un ambiente real; se ejecutan interactivamente y en tiempo real; son capaces de alinear geométricamente objetos virtuales y reales en el mundo real. La tecnología de RA ha sido aplicada en campos como: turismo, entretenimiento, mercadeo, cirugías, logística, manufactura, mantenimiento y otros [Westerfield et al. [2015] [Santos et al. [2015]. Las tecnologías de Realidad Aumentada (RA) para respaldar las operaciones industriales, como mantenimiento, por ejemplo, han sido un tema de investigación académica durante los últimos 50 años. En la última década, se han logrado avances importantes y la tecnología RA está cada vez más cerca de ser implementada en la industria.

La visión por computadora y la RA se centran en la reconstrucción 3D de un objeto con el fin de improvisar el efecto visual Swarna [Priya et al. [2017], [Chen et al. [2018]. En [Abu Alhaija et al. [2018] describen como la RA se une a la visión por computadora. Ellos proponen una alternativa que combina datos reales y sintéticos donde la segmentación de objetos juega un papel importante. Explotan el hecho de que no todos los objetos de la escena son igualmente importantes, proponen aumentar las imágenes del mundo real con objetos virtuales. Capturan imágenes del mundo real a gran escala y proporcionan diferentes aspectos reales de fondo sin la necesidad de crear modelos 3D complejos del entorno. En este trabajo, presentan un procedimiento eficiente para aumentar estas imágenes con objetos virtuales.

PROYECTO 1:

CALIBRATION OF SPATIAL AUGMENTED REALITY (SAR)

Descripción:

- La calibración del sistema SAR está orientada a dos objetivos principales: Calibración geométrica y calibración fotométrica

1. Calibración geométrica

Los métodos de calibración geométrica se centran en el modelado de la forma exacta de la superficie de proyección, así como en los parámetros internos y externos de los proyectores y cámaras utilizados:

A. Calibración geométrica del proyector. El video proyector debe calibrarse para calcular la imagen correcta. Por lo tanto, sus parámetros intrínsecos, como el centro óptico y la distancia focal, deben determinarse. Aunque son intrínsecos al proyector e independientes de la aplicación de realidad aumentada espacial, los fabricantes rara vez proporcionan estos parámetros, ya que cambian con la resolución de la pantalla y, por lo tanto, la relación de aspecto involucrada, así como el factor de zoom cuando está disponible.

B. Calibración de la cámara. La calibración de la cámara es el proceso de determinar los parámetros de la cámara (parámetros intrínsecos) y la relación con respecto al proyector (parámetros extrínsecos).

C. Calibración de la superficie de proyección. Este paso consiste en determinar la posición, orientación y forma del objeto del mundo real que será usado como superficie de proyección, con respecto al video proyector. La superficie de proyección se considerará dinámica y no rígida.

2. Calibración radiométrica

Las tareas de calibración fotométrica apuntan a la estimación del procesamiento interno del color de los dispositivos de entrada y salida utilizados, así como a las propiedades de reflectancia de las superficies para proyectar. Se desarrollaran enfoques de visualización computacional para superar las limitaciones técnicas del hardware de proyección actual en términos de rango dinámico, frecuencia de actualización, resolución espacial, profundidad de campo, dependencia de la vista y espacio de color. Estas tecnologías contribuyen a crear nuevos dominios de aplicación relacionados con los basados en proyección espaciales .

PROYECTO 2.

SPATIAL AUGMENTED REALITY APPLICATION

Las operaciones de mantenimiento y reparación representan un dominio de problemas interesante y lleno de oportunidades para la aplicación de la realidad aumentada. La mayoría de las actividades en este dominio son realizadas por personal de mantenimiento capacitado que aplica procedimientos establecidos a diseños documentados en entornos relativamente estáticos y predecibles. Estos procedimientos generalmente se organizan en secuencias de tareas cuantificables dirigidas a un elemento en particular en una ubicación específica. Estas y otras características forman un espacio de diseño bien definido, adecuado para una variedad de sistemas y tecnologías que podrían ayudar a un técnico a realizar el mantenimiento. Las secuencias de mantenimiento también pueden ser difíciles de atravesar cognitivamente porque requieren técnicas para colocar primero una tarea determinada en un modelo supuesto del entorno y luego identificar correctamente esta ubicación en el mundo físico. Este problema es particularmente grave cuando se mantienen sistemas complejos, como los que se encuentran en dominios industriales, militares y aeroespaciales. Las secuencias de mantenimiento en tales sistemas típicamente abarcan docenas de tareas que involucran objetos potencialmente desconocidos distribuidos aleatoriamente en un área determinada.

El sistema propuesto consiste en una ayuda inteligente de ensamblaje/desensamblaje para la generación automatizada de secuencias de ensamblaje y escenas AR y una interfaz mejorada, con el objetivo de maximizar el uso del conocimiento existente mientras se crean instrucciones vívidas de servicio SAR. Se desarrollarán y documentarán cómo SAR puede ayudar a reducir el tiempo y el esfuerzo en navegar secuencias más grandes de tareas de mantenimiento en sistemas tan complejos. Se describirán el diseño y las pruebas de usuario de un prototipo de aplicación SAR para ayudar a los técnicos a navegar secuencias de montaje/desmontaje realistas y desafiantes. La aplicación utilizará SAR para mejorar la localización en secuencias de mantenimiento estándar con instrucciones en pantalla, símbolos que dirigen la atención, etiquetas superpuestas, gráficos 2D y 3D de contexto y secuencias animadas.

Proyectos futuros

3D visualization data rendering

Voice command development in SAR experiences that enable factory workers to perform industrial task.

Gesture commands development in SAR experiences that enable factory workers to perform in noisily industrial environment their taks.

Virtual Data Manipulations using voice or gesture comands.

Physical Objects Manipulations using voice or gesture comands.

Virtual volume zooming using voice or gesture comands.

Colaboradores:

Dr. José-Joel González-Barbosa

Dr. Juan Bautista Hurtado-Ramos

Dr. Francisco Javier Ornelas-Rodríguez

Dr. Paulo Menezes (ISR-Universidade Coimbra)

Dr. Erick Alejandro González Barbosa (ITESI-Irapuato)

M. Karen Lizbeth Flores-Rodriguez

Dr. Alfonso Ramírez Pedraza ( Centro de Investigaciones en Óptica A. C. )

Dr. Angel Ivan García Moreno (CIDESI)

Bibliografía:

Krichenbauer, G. Yamamoto, T. Taketom, C. Sandor, and H. Kato. Augmented reality versus virtual reality for 3d object manipulation. IEEE Transactions on Visualization and Computer Graphics, 24(2):1038–1048, Feb 2018. ISSN 1077-2626. doi: 10.1109/TVCG.2017.2658570.

P. Milgram and F. Kishino. Taxonomy of mixed reality visual displays. IEICE Transactions on Information and Systems, E77-D(12):1321–1329, 1994.

R. Azuma, Y. Baillot, R. Behringer, S. Feiner, S. Julier, and B. MacIntyre. Recent advances in augmented reality. IEEE Computer Graphics and Applications, 21(6):34–47, 2001. doi: 10.1109/38.963459.

G. Westerfield, A. Mitrovic, and M. Billinghurst. Intelligent augmented reality training for motherboard assembly. International Journal of Artificial Intelligence in Education, 25(1):157–172, 2015.

M. Santos, J. Polvi, T. Taketomi, G. Yamamoto, C. Sandor, and H. Kato. Toward standard usability questionnaires for handheld augmented reality. IEEE Computer Graphics and Applications, 35(5):66–75, 2015. doi: 10.1109/MCG.2015.94.

R. Swarna Priya, S. Aarthy, C. Gunavathi, P. Venkatesh, S. Koppu, and X.-Z. Gao. 3d reconstruction of a scene from multiple 2d images. International Journal of Civil Engineering and Technology, 8(12):324–331, 2017.

L. Chen, W. Tang, N. John, T. Wan, and J. Zhang. Slam-based dense surface reconstruction in monocular minimally invasive surgery and its application to augmented reality. Computer Methods and Programs in Biomedicine, 158:135–146, 2018. doi: 10.1016/j.cmpb.2018.02.006.

H. Abu Alhaija, S. Mustikovela, L. Mescheder, A. Geiger, and C. Rother. Augmented reality meets computer vision: Efficient data generation for urban driving scenes. International Journal of Computer Vision, pages 1–12, 2018. doi: 10.1007/s11263-018-1070-x.

Digitalización urbana

PROYECTO 1:

CONSTRUCCIÓN DE MAPAS URBANOS MEDIANTE CARACTERÍSTICAS VISUALES Y ESPACIALES PARA APLICACIONES EN ADMINISTRACIÓN URBANA

Objetivo:

Desarrollar e implementar un módulo de digitalización urbana que permita obtener una descripción de los elementos viales del entorno (señales viales, semáforos, postes de luz, lámparas) de manera autónoma para ser aplicado en administración urbana como en tareas realizadas por la Secretaría de Comunicaciones y Transporte (inventariado, mantenimiento, preservación, etc.) mediante la detección de características cuantitativas (posición satelital, tamaño, conteos, existencia, etc.) y cualitativas (deterioro, grafiti, daño, etc.) haciendo uso de información visual adquirida por cámaras panorámicas (LadyBug), información espacial adquirida por sensores láser (LiDAR) y GPS.

Recursos disponibles:

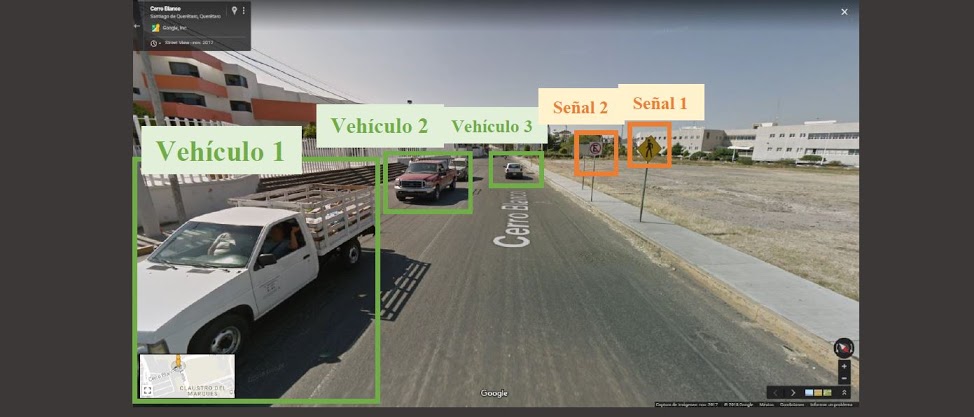

Figura II. Se observa la detección de los objetos más cercanos al sistema de adquisición de datos. Se clasifican en su perteneciente más cercano. Estos objetos, además de su clase se describen. Ejemplo: Descripción del entorno, la calle es de dos sentidos. Vehículo 1 (camioneta de carga blanca), Vehículo 2 (camioneta roja), Vehículo 3 (automóvil blanco), Señal 1 (señal de cruce peatonal, se espera cruce de cebra), Señal 2 (señal de prohibido estacionarse, se espera banqueta amarilla). Conteo de árboles: No hay árboles. [Imagen google maps]

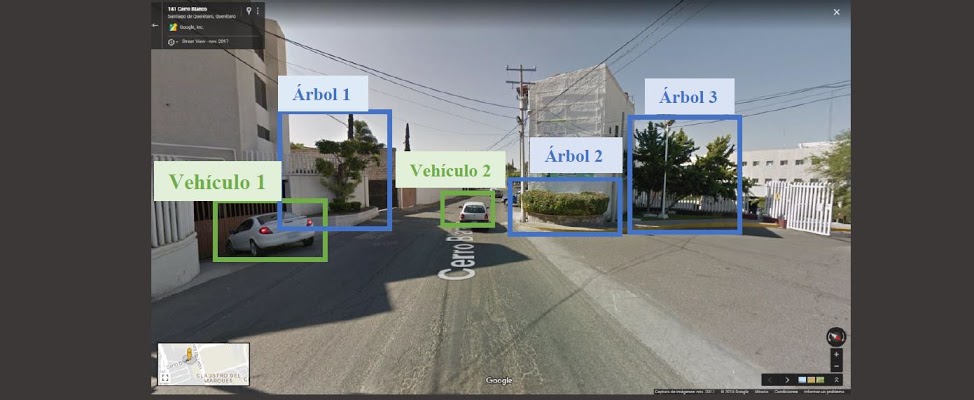

Figura III. Se observa la detección de los objetos más cercanos al sistema de adquisición de datos. Se clasifican en su perteneciente más cercano. Estos objetos, además de su clase se describen. Ejemplo: Descripción del entorno, la calle se divide. Vehículo 1 (automóvil blanco), Vehículo 2 (automóvil blanco), Árbol 1 (dimensiones espaciales: altura 2 m, radio 0.5 m), Árbol 2 (dimensiones espaciales: altura 0.5 m, arbusto), Árbol 3 (dimensiones espaciales: altura 3 m, radio 1.5 m,). Conteo de árboles: 3. [Imagen: google maps].

Colaboradores:

Dr. José-Joel González-Barbosa

Dr. Juan Bautista Hurtado-Ramos

Dr. Francisco Javier Ornelas-Rodríguez

Dr. Erick-Alejandro González-Barbosa (ITESI-Irapuato)

M. Karen Lizbeth Flores-Rodriguez

Dr. Alfonso Ramírez Pedraza ( Centro de Investigaciones en Óptica A. C. )

Dr. Angel Ivan García Moreno (CIDESI)

Plataforma universal de evaluación y caracterización de robots

PROYECTO 1:

SOFT ROBOTS

Este proyecto plantea el desarrollo de una plataforma de escaneo 3D de visión activa que permita evaluar y caracterizar el desempeño de estructuras deformables en función de la carga o estímulo de excitación. La información que arroje el sistema a partir de la evaluación de las estructuras deformables será de utilidad para definir parámetros o criterios de diseño, establecer numéricamente efectos de errores de manufactura en el comportamiento de las estructuras deformables. Asimismo, la información obtenida de la caracterización de las estructuras deformables permitirá establecer modelos matemáticos (deformación-estímulo) a partir de datos experimentales. Por otro lado, se plantea que al tener un sistema de escaneo 3D será posible medir otras variables como velocidad, deformaciones concentradas en una zona de interés, variación de la rigidez en función de la geometría de la estructura o errores de ensamble durante el proceso de manufactura por moldeo. La principal aportación que plantea esta investigación se enfoca en el área de robótica deformable, pues actualmente las plataformas de evaluación y caracterización de estructuras deformables están limitadas al seguimiento y reconocimiento de objetos en el plano, a través de la técnica de tracking 2D. La propuesta de este proyecto es multidisciplinaria, se plantea trabajar en conjunto las líneas de investigación de Análisis de Imágenes y Mecatrónica.

Colaboradores:

Dr. José-Joel González-Barbosa

Dra. Xochilt Yamile Sandoval Castro

M. I Maximiano Francisco Ruiz Torres

Dr.Erick Alejandro González-Barbosa (TECN-Irapuato)

PROYECTO 2:

CALIBRACIÓN DE ROBOTS

La automatización ha aumentado el número de robots para realizar muchas tareas industriales al rededor del mundo. La Federación Internacional de Robótica(IFR) publicó registros donde mencionan que 3.01 millones de robots estabanen funcionamiento en todo el mundo en el 2020. La IFR espera que a partir del 2021, esta cifra se vea aumentada en mas de 400 mil unidades anuales [1]. Sin embargo, en los robots pueden existir errores en el posicionamiento y se deben a la desviación de los parámetros nominales o de diseño en comparación con los parámetros reales. Esto puede suceder debido a errores de manufactura y ensamblaje [2, 3], tiempo de uso del robot, material utilizado para su construcción[4], la temperatura [5], fuerzas de corte [6]. Estas diferencias afectan principalmente a los parámetros geométricos del modelo cinemático directo e inverso, introduciendo errores a las longitudes de los eslabones (∆li) y a los valores angulares de las articulaciones (∆θi). El objetivo de este proyecto es desarrollar una plataforma de visión capaz de calcular estas variaciones, con el propósito de realizar una compensación o calibración del robot y reducir el error entre la posición deseada y la posición del efector final.

Colaboradores:

Dr. José-Joel González-Barbosa

Dra. Xochilt Yamile Sandoval Castro

M. I Maximiano Francisco Ruiz Torres

Dr.Erick Alejandro González-Barbosa (TECN-Irapuato)

Bibliografía:

[1]. IFR, Executive summary WR 2020 industrial robots, October 9, 2021.https://ifr.org/free-downloads/

[2]. Zha, J., Zhang, H., Chen, Y.: Implementation and Validation of Thor 3D Printed Open Source Robotic Arm. IEEE Latin America Transactions18(5),3641–3648 (2020). https://doi.org/https://doi.org/10.1007/s00170-019-04828-2,

[3]. Li,F.,Zeng,Q.,Ehmann,K.F.,Cao,J.,Li,T.:A calibration method for over constrained spatial translational parallel manipulators. Robotics and Computer-Integrated Manufacturing 57,241–254(2019). https://doi.org/https://doi.org/10.1016/j.rcim.2018.12.002,

[4]. Junia Santillo Costa, J., de Urzedo Machado, T., Lajovic Carneiro, M.: Astrategy to evaluate and minimize parallelism errors of a rotor system ina precision rotary table. Int J Adv Manuf Technol106(1), 907–913 (2020),https://link.springer.com/article/10.1007/s00170-019-04828-2

[5]. Santolaria,J.,Yague,J.A.,Jiménez,R.,Aguilar,J.J.:Calibration based thermal error model for articulated arm coordinate measuring machines. Precision Engineering 33(4),476–485(2009).https://doi.org/https://doi.org/10.1016/j.precisioneng.2009.01.002,

[6]. Olsson, T., Haage, M., Kihlman, H., Johansson, R., Nilsson, K., Roberts-son, A., Bjorkman, M., Isaksson, R., Ossbahr, G., Brogardh, T.: Cost-efficient drilling using industrial robots with high-bandwidth force feed-back. Robotics and Computer Integrated Manufacturing 26(1),24–38(2010). https://doi.org/https://doi.org/10.1016/j.rcim.2009.01.002